비교적 저렴한 비용으로 GPU 서버를 deploy 할 수 있는 runpod.io 서비스를 활용하여 .safetensors (.hf 라고 부르기도 함) 형식의 AI 모델을 .gguf 형식의 모델로 변환하는 자동화 스크립트입니다.

runpod 계정에 $10 이상 과금 후 아래의 과정을 진행합니다.

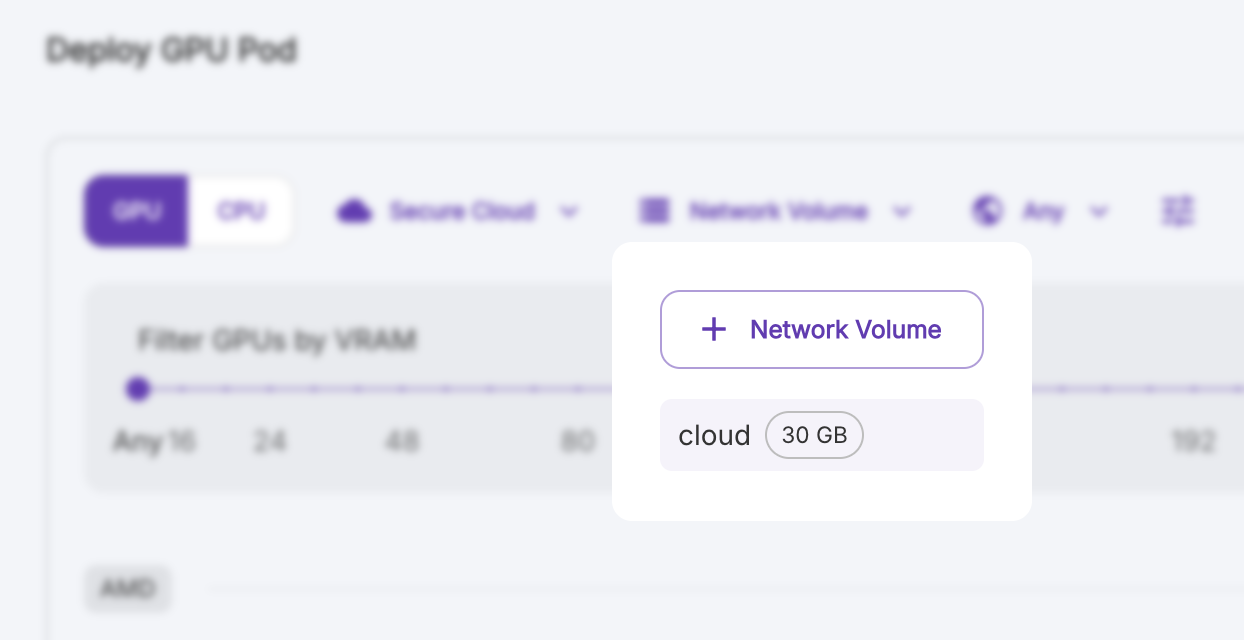

충분한 storage 환경을 위해 추가 스토리지를 구매해야 합니다. Create Network Volume > EU-SE-1 선택, 100GB를 할당합니다.

앞서 만든 network volume 선택,

GPU는 NVIDIA A40 선택 후 deploy 합니다.

deploy 한 서버 화면의 Connect 버튼을 클릭하면 웹 터미널에 접근할 수 있습니다.

runpod 에서 서버를 deploy 한 최초 상태인 root 유저로 실행해야 합니다.

curl -sSL "https://raw.githubusercontent.com/MediChat-ai/backend-ai/refs/heads/main/hf-to-gguf.sh" | bash -s <model_name>